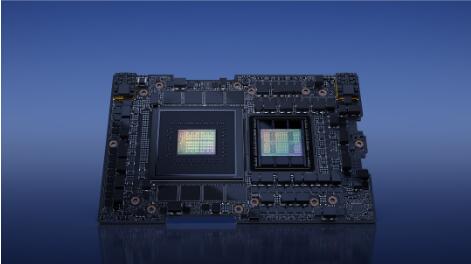

2023年5月29日,NVIDIA宣布NVIDIA® GH200 Grace Hopper超级芯片全面投产,将为全球各地即将上线的系统提供运行复杂AI和HPC工作负载所需的动力。

这些由GH200驱动的系统将加入由基于NVIDIA Grace™、NVIDIA Hopper™ 、NVIDIA Ada Lovelace和NVIDIA BlueField®等NVIDIA最新CPU,GPU和DPU架构的不同组合驱动的400多种系统配置中,以满足市场对生成式AI的激增需求。

在COMPUTEX上,NVIDIA创始人兼首席执行官黄仁勋公布了新系统、合作伙伴以及关于GH200 Grace Hopper超级芯片的更多细节。这款产品使用NVIDIA NVLink®-C2C互连技术,将基于Arm的NVIDIA Grace CPU和Hopper GPU架构互联,实现了高达900GB/s的总带宽,比传统加速系统中的标准PCIe Gen5通道高出7倍,提供了惊人的算力,能够满足要求最苛刻的生成式AI和HPC应用。

NVIDIA加速计算副总裁Ian Buck表示:“生成式AI正在迅速带来业务变革,解锁医疗、金融、商业服务等行业的新机遇并加速这些行业的研发工作。随着Grace Hopper超级芯片的全面投产,全球的制造商很快将会提供企业使用专有数据构建和部署生成式AI应用所需的加速基础设施。”

欧洲和美国的全球超大规模云服务商和超算中心是将会是接入GH200驱动的系统的客户之一。

数百个加速系统和云实例

全球众多系统制造商正在推出多种由NVIDIA 加速器和处理器的不同组合驱动的各种系统,其中台湾地区的制造商包括AAEON、 Advantech、Aetina、ASRock Rack、ASUS、GIGABYTE、Ingrasys 、Inventec、Pegatron、QCT、Tyan、Wistron 和Wiwynn等,在今天NVIDIA创始人兼CEO黄仁勋的COMPUTEX主题演讲中作为主要的合作伙伴被提及。

此外,全球服务器制造商 Cisco、Dell Technologies、Hewlett Packard Enterprise、Lenovo 等以及Atos集团旗下的Eviden正在提供各种NVIDIA加速系统。

NVIDIA H100的云合作伙伴包括AWS、Cirrascale、CoreWeave、Google Cloud,、Lambda、Microsoft Azure、Oracle Cloud Infrastructure、Paperspace和Vultr等。

NVIDIA L4 GPU现已在Google Cloud上可用。

跨加速系统的全栈式计算

即将推出的由NVIDIA Grace、Hopper和Ada Lovelace架构加速的系统一系列产品为NVIDIA AI、NVIDIA Omniverse™平台、NVIDIA RTX™技术在内的NVIDIA软件栈提供广泛的支持。

NVIDIA AI Enterprise作为NVIDIA AI平台的软件层,提供了100多个框架、预训练模型和开发工具,以简化包括生成式AI、计算机视觉和语音AI在内的生产型AI的开发和部署。

NVIDIA Omniverse开发平台用于构建和运行元宇宙应用,它使个人和团队能够跨多个软件套件开展工作并在共享环境中进行实时协作。该平台基于Universal Scene Description框架——一种用于虚拟世界的开放的、可扩展的3D语言。

NVIDIA RTX平台融合了光线追踪、深度学习和光栅化技术,通过支持业内领先的工具和API,从根本上改变了内容创作者和开发者的创作流程。建立在RTX平台上的应用带来了实时逼真渲染以及AI增强的图形、视频和图像处理能力,使数百万设计师和艺术家能够创造出自己的最佳作品。

供货情况

配备GH200 Grace Hopper超级芯片的系统预计将在今年晚些时候开始供应。

2022-12-27

CIP Security新增基于设备的防火墙配置以进一步提高EtherNet/IP网络安全性

2023-11-15

2024-10-13

2023-07-31

2024-10-09

2024-04-29

2024-09-03

2024-01-10

2023-08-21

安谋科技举办智能物联生态研讨会,“万物智联”时代共谋计算产业新未来

2023-10-26